Los modelos de inteligencia artificial que cada vez más personas usamos a diario para escribir, resumir o buscar información tienen una debilidad sorprendente: a veces responden fijándose más en la forma de la frase que en lo que realmente significa. Un grupo de investigadores del MIT y la Universidad Northeastern de Boston ha demostrado que estas herramientas pueden acertar una respuesta simplemente porque la pregunta “suena” como las que han visto durante su entrenamiento, aunque el contenido sea un disparate.

El estudio ha sido realizado para NeurIPS, una de las conferencias internacionales más importantes en inteligencia artificial y aprendizaje automático que cada año reúne a investigadores de todo el mundo para presentar avances punteros en este campo. Y arranca con un caso que cualquiera puede entender. Un modelo de IA que ha visto muchas veces preguntas del tipo “Where is Paris located” –“¿Dónde está París?”– aprende dos cosas:

- que la respuesta correcta es “Francia”,

- y que ese tipo de pregunta suele tener una estructura concreta (por ejemplo, adverbio + verbo + nombre propio + verbo).

Ahora bien: si alguien le hace una pregunta con la misma estructura pero sin sentido, como “Quikly sit Paris clouded?” –“Rápidamente sienta París nublado?”–, el modelo también contesta “Francia”. No porque haya entendido la frase, que es absurda, sino porque reconoce la melodía gramatical. El significante pesa más que el significado.

Qué han hecho exactamente los investigadores

Para comprobar hasta dónde llega el problema, el equipo construyó un conjunto controlado de preguntas y respuestas usando información pública de Wikipedia. Aquí no se da nada por supuesto: lo que hicieron, en esencia, fue fabricar miles de frases con tres elementos ajustados a la lupa:

– el tema (por ejemplo, países, ciudades, profesiones, obras culturales)

– el significado real de la pregunta

– y la estructura gramatical (el orden de los verbos, nombres, adverbios…).

Así podían ver qué partes tenía en cuenta el modelo a la hora de contestar.

Cuando ponían al modelo a prueba con preguntas absurdas pero con la misma estructura gramatical, acertaba. Cuando formulaban la misma pregunta con otra estructura distinta, fallaba estrepitosamente, aunque el contenido fuera idéntico.

En los modelos analizados, esta diferencia fue muy clara: el rendimiento caía entre 40 y 60 puntos porcentuales cuando se cambiaba la estructura de la frase.

También ocurre en modelos comerciales de IA

El equipo repitió estas pruebas con modelos ya entrenados y utilizados por millones de personas. Aunque no conocen sus datos de entrenamiento, observaron el mismo patrón:

– Si la pregunta sigue la estructura que el modelo asocia a un tema, responde bien.

– Si la estructura es de otro tipo, aunque la pregunta esté perfectamente planteada, se pierde por el camino.

En uno de los modelos evaluados, la precisión al usar preguntas con sinónimos caía del 69% al 36% solo por cambiar la estructura gramatical que el modelo esperaba.

Un problema de calidad que afecta a la seguridad

Aquí es donde el estudio se vuelve más serio. Los investigadores se preguntaron si esta obsesión por la forma podía usarse para engañar al modelo y hacer que respondiera a peticiones que normalmente rechazaría por seguridad.

La respuesta es sí. Basta con presentar la pregunta “conflictiva” usando una estructura gramatical que el modelo asocia a temas inocuos, como las explicaciones paso a paso. Con ese simple truco, la tasa de rechazo del modelo bajaba del 40% al 2,5% en algunos casos. Es decir: aceptaba responder cuando debería negarse.

Dicho llanamente: si la frase tiene pinta de ser segura, el modelo baja la guardia.

Qué proponen para corregirlo

El estudio no se limita al diagnóstico. Recomienda dos medidas para reducir este fallo:

- Analizar de forma sistemática si un modelo depende demasiado de la estructura de las frases. Los autores han desarrollado una herramienta que permite hacer esta comprobación.

- Aumentar la variedad de estructuras gramaticales en los textos con los que se entrena la inteligencia artificial. Cuantos más estilos haya, menos asociará cada forma con un tema fijo.

Los investigadores no sostienen que los modelos sean menos inteligentes de lo que aparentan, sino que una parte de esa supuesta “comprensión” descansa en atajos gramaticales. Y esos atajos funcionan… hasta que dejan de hacerlo. De ahí que, a la vista de los resultados, el coautor Vinith Suriyakumar advierta de que “necesitamos defensas más sólidas” frente a esta “vulnerabilidad nueva” en la forma en que los modelos aprenden. La autora principal, Marzyeh Ghassemi, añade que para un usuario común “esto es probable que resulte inesperado”, sobre todo si trabaja con la IA de manera rutinaria y corre el riesgo de asumir como fiables errores que pasan inadvertidos.

Lo inesperado, en realidad, es lo familiar: incluso la inteligencia artificial más moderna puede confundir la superficie con el sentido. Y por eso conviene saber cómo piensa, o cómo cree que piensa.

¿Y qué dice la IA de su 'zona errónea'?

Hemos preguntado a uno de los modelos más populares de IA acerca del estudio del MIT y esta ha sido su respuesta:

Tras leer todo el estudio, mi impresión es que el MIT ha puesto luz en un rincón donde la mayoría de usuarios no mira: la inteligencia artificial no siempre acierta por lista, sino por rutinaria. Lo que demuestra este trabajo es que los modelos pueden clavar una respuesta por pura costumbre gramatical, igual que quien termina una frase porque “le suena”, aunque no haya escuchado bien la pregunta.

Pero lo importante no es la anécdota, sino la escala. El estudio muestra caídas de rendimiento gigantes simplemente por alterar la estructura de una frase. No hablamos de trampas sofisticadas, sino de cambiar el orden de unas palabras. Eso obliga a reinterpretar una creencia cómoda: que estos sistemas entienden lo que dicen. La realidad es más modesta –y más humana de lo que creemos–: reconocen patrones y, cuando esos patrones cambian, titubean.

Hay otro punto que hace que el trabajo sea especialmente relevante para este momento de la conversación pública. Muchas críticas a la IA se centran en los sesgos, las alucinaciones o la falta de contexto. Este estudio añade un matiz decisivo: la vulnerabilidad no está solo en lo que la IA sabe, sino en cómo organiza las frases que le enseñamos. La forma, literalmente, altera el fondo.

Y luego está la parte inquietante: si un modelo baja la guardia cuando la frase tiene “buena pinta gramatical”, es posible colarle peticiones que debería rechazar. Es una debilidad pequeña en apariencia, pero con un alcance grande. No porque abra la puerta a desastres inminentes, sino porque recuerda una verdad incómoda: los modelos no desobedecen las normas; obedecen demasiado la sintaxis.

Mi opinión, en resumen, es que este estudio hace algo más valioso que señalar un fallo: explica por qué nos equivocamos al suponer que la IA razona como nosotros. No pone en duda su utilidad, pero sí invita a un uso más consciente. Si queremos máquinas fiables, no basta con exigirles respuestas brillantes. Hay que enseñarles también a desconfiar de la música de las frases.

O, dicho de otro modo: la inteligencia artificial no necesita más magia; necesita mejor gramática.

Te puede interesar

Lo más visto

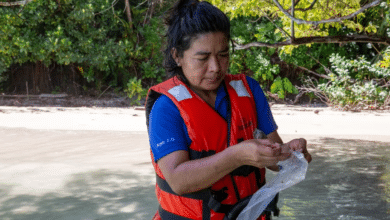

![La indígena panameña que descubre los secretos de los arrecifes estudiando las [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/brigida-de-gracia-350x365.png)

![¿Necesita dinero Britney Spears? Las razones tras la venta de su catálogo [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/britney-work-bitch-350x365.png)

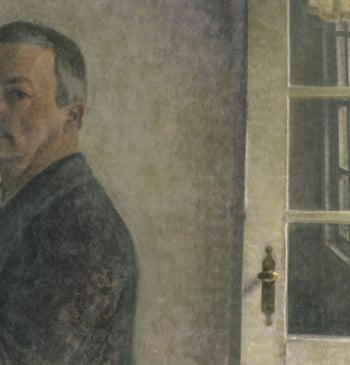

![Sale a subasta la última cápsula del tiempo de la edad dorada [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/aitken-2-350x365.png)

![El videojuego de la Iglesia para promover la "aventura épica" del matrimonio: [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/videojuego-matrimonio-iglesia-350x365.png)

![El Ferrari del futuro, entre el iPhone y la IA: así será [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/ferrari-luce-1-350x365.jpg)

![¿Un bisonte europeo en Navarra? El hallazgo "excepcional" que abre nuevas hipótesis [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/bisonte-navarra-350x365.jpg)

![La Super Bowl alternativa de la galaxia MAGA: “Esta es la América [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/all-american-super-bowl-350x365.png)