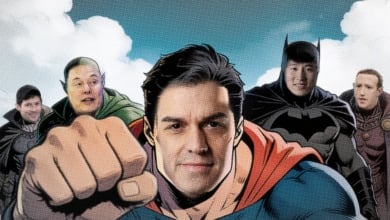

El algoritmo de X empuja a sus usuarios hacia posiciones políticas más conservadoras, y sus efectos persisten incluso cuando se apaga. Es la principal conclusión de un experimento publicado en la revista Nature que pone bajo foco el poder político de las grandes plataformas digitales. En pleno debate sobre la regulación de las plataformas y la transparencia de sus sistemas de recomendación -con pelea de Sánchez con los que é llama tecnoligarcas como Elon Musk- este nuevo trabajo en Nature sugiere que el diseño del feed de una red social no es un detalle técnico, sino una pieza de las condiciones estructurales en las que se forman las opiniones políticas.

Entre el verano y el otoño de 2023, el equipo liderado por la economista Ekaterina Zhuravskaya siguió durante unas siete semanas a 4.965 usuarios activos de X en Estados Unidos, a los que asignó aleatoriamente a dos entornos informativos distintos: el feed algorítmico “Para ti” o el cronológico “Siguiendo”. Los participantes respondieron encuestas antes y después del experimento, y una extensión de navegador permitió saber qué veían exactamente en su timeline, qué cuentas seguían y cómo interactuaban con los contenidos.

Los resultados muestran que quienes utilizaron el modo “Para ti” no solo usaron más la red social, sino que desplazaron sus prioridades políticas hacia posiciones más conservadoras, con más peso para cuestiones como la inmigración, el crimen o la inflación. También tendieron a alinearse con posiciones republicanas en la valoración de las investigaciones penales contra Donald Trump y en sus opiniones sobre la guerra en Ucrania. En paralelo, empezaron a seguir con mayor frecuencia a activistas políticos conservadores, mientras que la visibilidad de los medios de comunicación tradicionales disminuía en sus feeds.

El estudio detecta además un efecto de asimetría temporal: activar el algoritmo tiene impacto medible, pero apagarlo apenas lo revierte. Cambiar a los usuarios del feed algorítmico al cronológico produjo pocos cambios en sus opiniones y hábitos de seguimiento, lo que sugiere que la exposición inicial al algoritmo reorganiza de forma duradera el ecosistema de cuentas que cada persona sigue y, por tanto, su dieta informativa futura.

“Se trata de una investigación rigurosa”, sostiene Ramón Salaverría, catedrático de Periodismo en la Universidad de Navarra, quien destaca tanto el tamaño muestral como el diseño experimental y el hecho de que el trabajo se haya realizado sin colaboración de X. A su juicio, el estudio confirma que el modo “Para ti” “propicia en los usuarios de X un desplazamiento hacia posiciones políticas más conservadoras”, asegura en declaraciones a Science Media Centre España. Salaverría matiza que el efecto es desigual: es limitado entre quienes se declararon progresistas, pero más intenso entre usuarios inicialmente conservadores o independientes, que evolucionan hacia posiciones aún más conservadoras. Salaverría advierte, no obstante, de que los resultados solo permiten afirmar este sesgo en Estados Unidos y en el periodo analizado, y que no pueden extrapolarse automáticamente a otros países o a toda la constelación de redes sociales.

Para Celia Díaz Catalán, investigadora del Instituto TRANSOC de la Universidad Complutense de Madrid, el trabajo es “una advertencia rigurosa sobre la plasticidad de las actitudes políticas frente a la arquitectura y diseño de las plataformas digitales”, afirma a Science Media Centre. La investigadora subraya que el diseño del ensayo -aleatorizado y con triangulación de encuestas y datos de comportamiento real- permite demostrar cómo el algoritmo altera tanto el flujo de información como la estructura de la red social de cada individuo. A diferencia de estudios previos de Meta que solo midieron qué pasaba al apagar el algoritmo, este experimento evalúa también el impacto de activarlo y captura “la persistencia del efecto generado por el modo algorítmico”, señala. Díaz Catalán llama la atención sobre otro hallazgo: el algoritmo “silencia a los medios de comunicación tradicionales” y deja un vacío que “llenan voces más radicales”, de modo que, si en un país las voces más activas y polarizadoras son conservadoras, el sistema tenderá a amplificarlas.

Belén Laspra, profesora de Filosofía en la Universidad de Oviedo, considera que la investigación aporta “una de las evidencias experimentales más sólidas hasta la fecha” sobre la relación entre algoritmos de recomendación y actitudes políticas. A su juicio, el experimento muestra que activar el feed algorítmico durante siete semanas genera desplazamientos significativos hacia posiciones más conservadoras en prioridades de política pública, en la valoración de las causas judiciales contra Trump y en las opiniones sobre la guerra de Ucrania, pero sin modificar la identificación partidista ni el grado de polarización afectiva entre demócratas y republicanos. “El algoritmo no convierte a los usuarios en votantes de otro partido”, resume, “pero sí modula cómo priorizan ciertos temas y cómo interpretan determinados acontecimientos dentro de marcos ideológicos ya existentes”.

Laspra destaca como aportación central la llamada “hipótesis de la persistencia”: que desactivar el algoritmo no produzca cambios apreciables “no implica que el algoritmo no haya tenido impacto previamente”, porque la exposición inicial puede haber reconfigurado de forma duradera la red de cuentas seguidas y el entorno informativo del usuario. Su lectura se amplía al plano sistémico: aunque solo alrededor del 21% de los adultos estadounidenses declara usar X, la plataforma concentra a periodistas, dirigentes políticos y responsables institucionales, de modo que lo que ocurre allí se filtra a los medios tradicionales, otros foros y la agenda política general. “La arquitectura del sistema puede intervenir en un espacio que tiene efectos más allá de sus usuarios directos”, advierte.

Te puede interesar

-

Sánchez busca rentabilizar la guerra contra los tecnoligarcas

-

Bruselas muestra su "total solidaridad" con Sánchez tras los ataques de Musk y Dúrov

-

El proyecto definitivo de Elon Musk: sacar los centros de datos al espacio en menos de tres años

-

Sánchez reitera que los "tecnócratas del algoritmo" no le van a "quebrar"

Lo más visto

![Gabriel Rufián y Emilio Delgado quieren pasar a la ofensiva en la [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/gabriel-rufian-y-emilio-delgado-350x365.jpg)

![La DANA de Valencia no fue una gota fría normal: el cambio [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/europapress-6314502-decenas-coches-amontonados-31-octubre-2024-sedavi-valencia-comunidad-350x365.jpg)

![Demetrio Madrid: “Felipe González está fuera de la realidad política española y [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/demetrio-madrid-350x365.jpg)

![Mayte Uceda: “Nuestros políticos tienen que desescalar, la violencia política siempre se [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/mayte-uceda-ap-27-scaled-e1771069673874-350x365.jpg)

![Máximo Huerta: “No conozco a ningún cuidador que no haya contestado mal [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/maximo-huerta-med-42-350x365.jpg)

![Tras Leonardo, llega Marta: Aemet alerta del impacto el sábado de un [...]](https://www.elindependiente.com/wp-content/uploads/2026/02/grazalema-9-rec-1-350x365.jpg)

Comentarios

Normas ›Para comentar necesitas registrarte a El Independiente. El registro es gratuito y te permitirá comentar en los artículos de El Independiente y recibir por email el boletin diario con las noticias más detacadas.

Regístrate para comentar Ya me he registrado