Margaret Boden, a sus 82 años, sigue siendo profesora de informática y ciencia cognitiva de la Universidad de Sussex (Reino Unido). También es psicóloga y filósofa. Es un referente mundial en el estudio de la Inteligencia Artificial (IA), campo en el que empezó a investigar en los años 50 del siglo pasado, antes incluso de que se llamara así.

Boden, que ha publicado recientemente un entretenido manual didáctico Inteligencia Artificial (Turner, 2017), analiza "el matrimonio entre inteligencia artificial y humanos" y tal vez lo más inquietante sea que "ya no hay ninguna posibilidad de divorcio", según la tecnóloga que participó en la Thinking Party 2018, un encuentro en la Fundación Telefónica en Madrid. La IA ya está en prácticamente todos los aspectos de nuestra vida cotidiana, empezando por nuestros móviles e incluyendo nuestros gobiernos, que ya no vamos a vivir sin ella. ¿Qué debemos esperar?

Inteligencia artificial vs. estupidez humana

¿Veremos en el 2050 robots que superen a los humanos? Esta octogenaria de pelo blanco, que camina con bastón, asegura que no le tiene miedo a que los robots puedan superar en inteligencia a los humanos. Y aclara que cuando habla de robots no se refiere a aparatos que se muevan por el suelo, sino a sistemas con los que interactuamos por voz o a través de pantallas.

Desde luego, según Boden, que continuamente se refiere a la inteligencia artificial y las máquinas que la hacen posible como "cosas" para dejar clara la diferencia, no podemos esperar que sea "un matrimonio entre iguales". Y añade: "Esta tecnología va a estar en todas partes en la sociedad humana y ahí la palabra clave es humana. Tenemos un futuro muy emocionante por delante, pero lo que sucederá es totalmente impredecible y eso debería preocuparnos", advierte.

- Margaret Boden, autora de «Inteligencia artificial» (Turner Minor, 2017)

Algunos futuristas como el director de ingeniería de Google, el controvertido Kay Kurzweil, se atreven a fechar en 2030 la singularidad, el momento en que la inteligencia artificial supere a la inteligencia humana. Para entonces, Kurzweil ha vaticinado que los cerebros humanos podrán conectarse a la nube, lo que nos permitirá mandar mensajes y fotos directamente al cerebro y recuperar nuestros pensamientos o recuerdos digitalmente. "Es la idea más estúpida", afirma Boden. "Ni siquiera entendemos cómo funciona el cerebro humano ni hemos dado respuesta ya no científica, sino filosófica, a qué es la conciencia humana... Ni puede que lo lleguemos a comprender nunca", afirma con contundencia. "Hay mucha gente prometiendo más de lo que esta tecnología puede jamás llegar a lograr. Es ignorante prometer cosas sinsentido".

Cree esta tecnóloga y filósofa que los robots no tendrán emociones ni serán, al menos antes de finales de este siglo, más inteligentes que los humanos. Aunque ya hay sistemas de IA mejores que los humanos en tareas concretas, como ganar al ajedrez al campeón del mundo por ejemplo. Ese mismo sistema luego no sabría jugar al parchís o escribir un poema.

"La idea de que todos los problemas de los seres humanos van a ser resueltos por los algoritmos no tiene sentido por dos razones", explica Boden en la Fundación Telefónica. "Primero, porque es demasiado difícil entender el cerebro humano y todavía no sabemos mucho sobre su funcionamiento; además, los robots no van a superarnos porque no quieren, no tienen objetivos propios ni ambición, carecen de sentimientos y de motivación para el poder", explica.

Lo que sí que preocupa a Boden del futuro de la inteligencia artificial, sin embargo, es lo que los humanos vayamos a hacer con ella. Porque en caso de acontecimiento catastrófico, la responsabilidad siempre será del ser humano. Insiste por tanto que hay que intentar que la IA no se descontrole, que debe regularse. "No existen los robots éticos, porque no tienen la culpa de lo que hacen", explicó en su conferencia. "La responsabilidad moral tiene que quedarse del lado del ser humano", añade. Y no oculta que le da miedo que pueda llegar a usarse la inteligencia artificial en una guerra armamentística en la que permitiera que los robots mataran humanos.

Expertos en inteligencia artificial de todo el mundo han intentado con la campaña Stop Killer Robots que se firme un acuerdo internacional para que los países miembros de Naciones Unidas se comprometan a no utilizar este tipo de armamento.Los robots podrían llegar a seleccionar y disparar objetivos de forma autónoma, pero siempre y cuando los humanos los hubieran programado para ello. Por eso, de momento, los expertos le tienen más miedo que los políticos al potencial asesino de los robots. No solo no existe un tratado, sino que no existe una definición de qué es y que no es un arma autónoma.

Lo que Boden tiene claro es que tanto la responsabilidad, como la culpa, igual que el daño, son conceptos humanos. De ahí que la profesora de Sussex no solo recurra a la informática y la programación para explicar los retos que nos plantea la inteligencia artificial para el futuro. También y, sobre todo, a la filosofía.

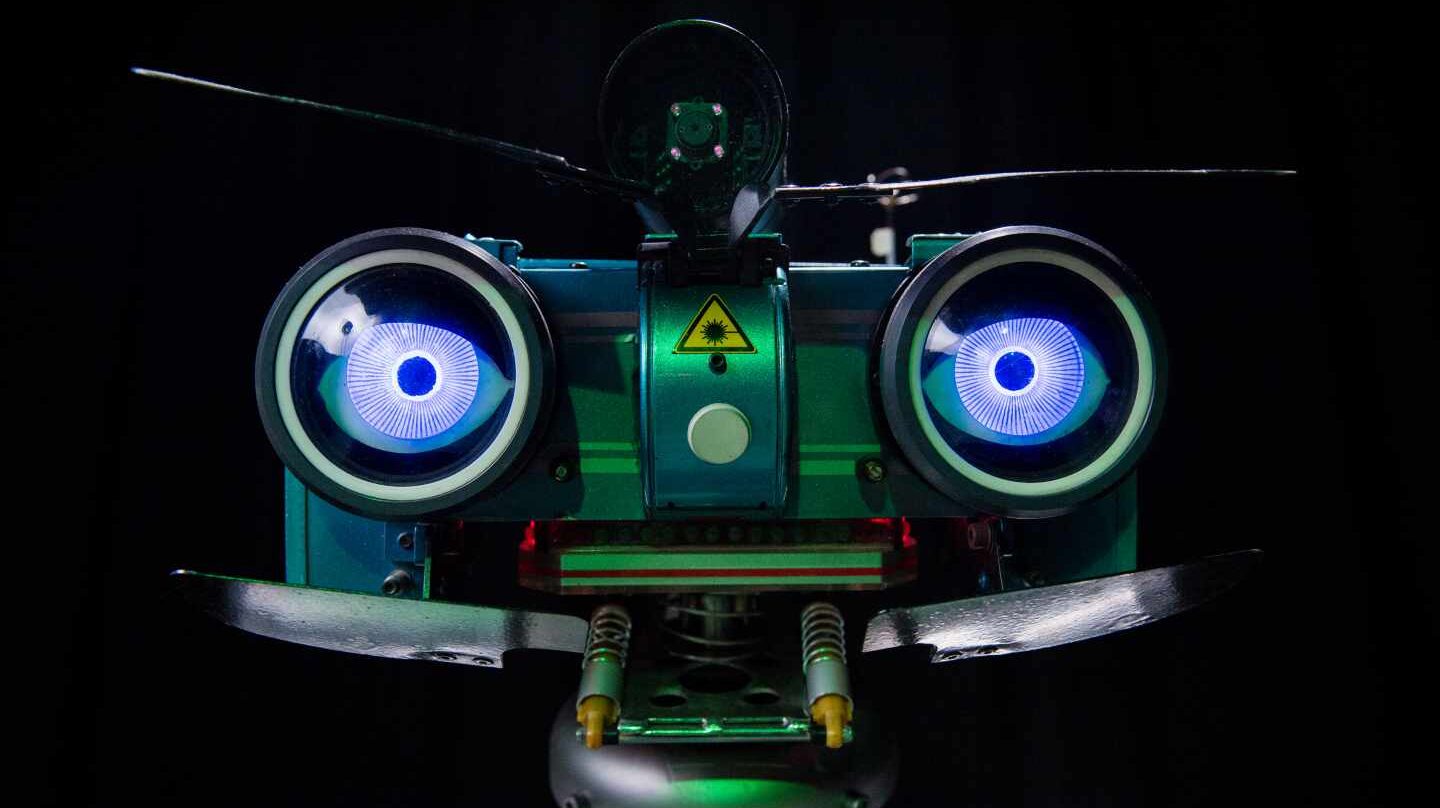

- Nao Robocup, 2008

Ética e Inteligencia Artificial

Según esta experta, que lleva más de cinco décadas estudiando las relaciones entre humanos e inteligencia artificial, hay un límite en las decisiones que podemos delegar en las máquinas. "Gracias a la inteligencia artificial, podemos llegar a un hospital y que una máquina nos detecte el tipo de enfermedad que tenemos y nos prescriba el medicamento más apropiado para tratarla. Pero la decisión de tomar esa droga solo puede ser humana", explica. ¿No puede saber la máquina qué es lo mejor? "No, qué es o no lo mejor es un concepto humano basado en nuestras prioridades personales y la cosa a lo mejor prescribe algo que nos puede alargar la vida un año pero eso no es lo que queremos a cualquier coste. A lo mejor, según nuestros criterios, no queremos alargar nuestra vida en determinadas condiciones. Eso no lo puede decidir un robot, eso tiene que ser una decisión que tomamos nosotros una vez que la máquina nos da la información", añade. "¿Decidir qué es o no lo mejor no es algo sencillo?"

Pero su duda va más allá: "¿Y si el sistema de inteligencia artificial se equivoca en su diagnóstico y nos prescribe el tratamiento equivocado? ¿A quién demandaríamos? ¿Al médico que consultó con IA? ¿Al programador? ¿A la empresa que vendió el sistema al hospital?", se pregunta Boden. "Los abogados van a estar encantados, hay mucho trabajo por ahí en el futuro", bromea. A donde quiere llegar con su razonamiento es que la culpa en última instancia va a estar asumida por un organismo en manos de humanos. Es ilógico a nivel filosófico pensar que puedan llegarse a tratar a los robots como personas, porque solo los humanos tenemos la responsabilidad y las motivaciones.

¿Es un problema que estemos delegando la toma de decisiones que solían ser humanas a las máquinas? “Sí", responde con rotundidad. "El problema es que perdemos la posibilidad de aprender a tomar las decisiones apropiadamente. Si a los jóvenes abogados se les enseña ahora a utilizar la IA para tomar decisiones y muchas de las búsquedas que hacen en sus sistemas se hacen mucho más rápidamente en las máquinas, una se puede preguntar si los abogados más jóvenes no están pasando, como pasaban generaciones anteriores, horas y horas leyendo y analizando esos casos para hacer analogías, ¿serían capaces de hacerlo si alguna vez se lo pidieran? ¿y podrán llegar a las mismas conclusiones que los abogados más senior en los casos más complejos? ¿Y qué pasará cuando ellos sean los abogados más senior porque la anterior generación se haya jubilado? ¿Tendrán las mismas capacidades?"

Boden no cree que sea posible conseguir una lista concreta de reglas éticas para dar a un robot por la misma razón que no parece posible que los humanos vayamos a consensuar una lista de leyes morales universales. Por eso somos los humanos quienes tenemos que empezarnos a tomar en serio sus limitaciones.

- Tron C2 , robot de 1980 expuesto en 'Nosotros los robots' de Fundación Telefónica

"Cuando los ordenadores empezaron a ser utilizados de forma general era común que se diera la circunstancia de que alguien llegara con una solución estúpida para algo y se excusara diciendo que es que era lo que había dicho el ordenador", Boden ríe. "Bueno, pero algún humano lo habrá programado para que llegue a esa conclusión y, en segundo lugar, algún humano podrá modificarlo". Y añade: "Hay una gran falta de comprensión de lo que pueden y no pueden hacer estas máquinas. Y desde la Escuela Primaria en adelante es importante que este matrimonio entre humanos e inteligencia artificial no se convierta en algo feo, porque hay mucho potencial para el bien".

Boden insiste en que existe mucho desconocimiento sobre lo que la IA puede y no puede hacer. Critica las falsas promesas sin base científica, pero también advierte a los teóricos: "En vez de preguntarnos constantemente hasta dónde puede llegar la inteligencia artificial, también hay que enseñarle a la gente dónde están sus límites". E insiste mucho en este punto: "Es importante enseñarles a los niños, desde la Educación Infantil y Primaria, a relacionarse con las máquinas y qué se puede esperar de ellas, porque van a vivir en un mundo en el que vamos a recurrir a ellas constantemente".

No solo habla de las fronteras tecnológicas, también las éticas. Y una de las nociones que más preocupa a Boden es la noción de que la IA puede servir para construir cuidadores computacionales para la gente mayor. "Hay que tener cuidado con lo que se espera de los robots para hacer compañía y cuidar a los ancianos, por ejemplo", explica Boden. Esta práctica que en países como Japón es cada vez más frecuente. El Gobierno de este país prevé que la industria nacional crezca a 400 mil millones de yenes (3.800 millones de dólares) para el 2035, cuando un tercio de la población de Japón tenga 65 años o más.

Recuerda Boden que entre las necesidades básicas de los seres humanos, siguiendo la pirámide de Maslow, está el sentido de pertenencia. Y, sin embargo, en las residencias de ancianos muchas de estas personas carecen de contacto con seres queridos. "Se está invirtiendo mucho dinero en robots para cuidar de los mayores", asegura. "Y no tengo nada en contra en que haya sistemas de inteligencia artificial para vigilar el estado de salud de los mayores o para su entretenimiento, lo que sí puede ser un problema es que se empleen para ofrecer confort emocional, es decir, que se desarrollen para ofrecer el tercer nivel de la pirámide de Maslow".

Cuando Boden explica en inglés por qué le parece terrible que se desarrollen robots para el cuidado tiene más sentido porque la palabra que se utiliza es care, que se puede traducir como cuidar o como preocuparse e interesarse por alguien. "Los robots no se interesan por ti, les das igual, no tienen sentimientos reales", explica. Y advierte también de que por mucho que se sofistique el lenguaje natural y se puedan mantener conversaciones con ellos que resulten reconfortantes esto no cambiará. De ahí el dilema ético que le supone prometer un robot que cuide de alguien.

"Imagina un robot que pudiera, a través de sus conversaciones con un anciano al que hace compañía, recoger todos los recuerdos de una persona y meterlos en un diario para que cuando fallezca sus familiares lo tengan de recuerdo", cuenta. Hay quien ya está especulando sobre ello y se supone que debería ser algo bueno. Piénsalo bien. ¿Querrías que tus hijos o tus nietos tuvieran acceso a todos tus recuerdos? Todos hemos hecho algo de lo que no estamos orgullosos o que no querríamos que supieran nuestros familiares". Y al decir esto se ríe, algo que, al menos todavía, sigue siendo competencia plenamente humana.

Te puede interesar

Lo más visto