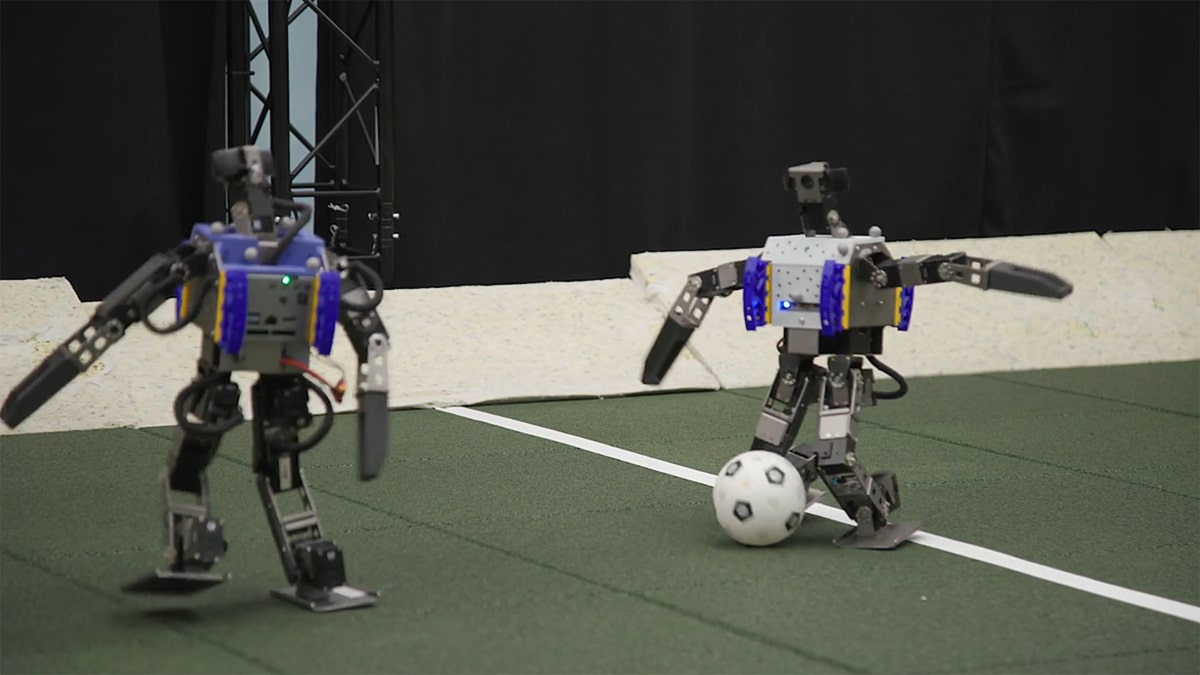

Del terreno de juego al laboratorio. El fútbol ha servido como herramienta para dotar a robots bípedos de mayor agilidad, destreza y comprensión del entorno. El aprendizaje de movimientos propios del fútbol ha facilitado la encarnación en un robot de muchas las características de la inteligencia sensoriomotora humana, que permite resolver problemas gracias a la percepción del entorno y el movimiento coordinado de distintas partes del cuerpo.

El estudio realizado por DeepMind Technologies, la compañía de Google dedicada a la investigación de la inteligencia artificial, y publicado en la revista Science Robotics, ha indagado en la capacidad del aprendizaje profundo por refuerzo (Deep RL) de sintetizar habilidades de movimiento sofisticadas para un robto humanoide.

Como si se tratara de un futbolista amateur que pasa por las manos de Carlo Ancelotti o Pep Guardiola, los robots han mejorado notablemente su rendimiento en los experimentos: corren un 181% más, giran un 302% más rápido, tardan un 63% menos en levantarse y chutan un 34% más fuerte. Todo ello gracias a la implementación del aprendizaje profundo por refuerzo, que ha conseguido un paso fundamental en la inteligencia artificial: dar atributos humanos a un robot para que pueda interactuar en el mundo con agilidad, destreza y comprensión.

Uno de los grandes logros de DeepMind Technologies es que, además de conseguir que el robot solucione situaciones complejas de control motor, ha aprendido movimientos ágiles y dinámicos, cómo desplazarse lateralmente, correr, disparar o recuperarse de caídas e interactuar con la pelota "de manera suave y flexible".

Las enseñanzas del uno contra uno a los robots

La voluntad de los investigadores pasa por convertir a los robots en "maestros de sus cuerpos", como lo son los animales y los humanos. El estudio señala que mediante los ejercicios de uno contra uno y con el aprendizaje profundo por refuerzo, los robots no solo han adquirido la capacidad de combinar movimientos complejos con fluidez y sin esfuerzo, sino que han comprendido cómo anticipar los movimientos de la pelota y bloquear los tiros del oponente.

"El agente descubrió estrategias inesperadas que hacían un uso más amplio de las capacidades del sistema que las alternativas programadas y que incluso podríamos haber concebido", apuntan los investigadores, que ponen como ejemplo el comportamiento de giro, en el que el robot pivota sobre un pie, lo que sería difícil de programar.

En el fútbol surgen situaciones imprevistas y muy dependientes del contexto, por lo que se generan importantes complicaciones difíciles de anticipar e implementar manualmente en un robot, de ahí que este conocimiento que interiorizan los humanoides es fundamental para su desarrollo.

Entrenamiento de robots

El entrenamiento de los robots, en el que han mejorado considerablemente sus prestaciones, se ha dividido en dos etapas. En la primera parte se ejercitaba cómo levantarse del suelo y cómo marcar un gol frente a un oponente sin adiestramiento. En la segunda, se entrenaba a los robots para el uno contra uno completo.

"El agente aprendió a combinar habilidades previamente aprendidas, refinarlas para el ejercicio de fútbol, y prever y anticipar el comportamiento del oponente", destaca el análisis, que apunta que solo se utilizaron habilidades preentrenadas para que el propio robot descubra comportamientos.

El resultado de DeepMind Technologies arroja una evolución de gran revelancia para la robótica, ya que los individuos utilizados han encarnado características propias de los humanos trasladables a otras utilidades.

"El agente exhibió una variedad de comportamientos emergentes, incluyendo movimientos ágiles como levantarse del suelo, una rápida recuperación de caídas, correr y girar; interación con objetos como control de la pelota y chutar, chutar con el balón en movimiento y bloquear tiros; y comportamientos estratégicos como defender colocándose entre el atacante y su propia portería y proteger el balón con su cuerpo", concluyen los investigadores de DeepMind Technologies.

Lo más visto