Es lo más cercano a leer la mente. Sólo que esa mente ha de llegarse a expresar en frases. Un equipo de la Universidad de California-San Francisco (UCSF) ha conseguido visualizar expresiones orales de un grupo de personas, observando los patrones cerebrales asociados a los movimientos de sus aparatos fonadores. Es decir, las órdenes del cerebro para mover laringe, cuerdas vocales, lengua o labios. Pero todo ello sin mirar a la boca ni escuchar sus palabras. Sólo midiendo la actividad de sus neuronas y pasándolas a una especie de traductor simultáneo que las sintetiza en una voz robótica. Algo así como el vocoder de Stephen Hawking 4.0.

"La prueba que buscas no está en los libros", "Construir barcos es un proceso de lo más fascinante" o "Gregory y Tom decidieron ver dibujos animados por la tarde" son frases que se pueden 'ver' en el cerebro. En concreto, las neuronas que se activan cuando son pronunciadas. Con la ayuda de algoritmos, se pueden traducir esas imágenes corticales en palabras y, de ahí, en sonidos, tal y como se muestra en este experimento.

Vídeo: Mario Viciosa / UCSF

Muchos pacientes con afecciones neurológicas y que pierden el habla dependen de dispositivos de comunicación que usan interfaces cerebro-ordenador u ojo/mejilla-ordenador. Quizás, el caso más famoso fuera el del profesor Hawking, quien prácticamente diseñó su propia herramienta para dirigir un cursor y seleccionar letras para construir virtualmente palabras. Hawking tardaba en torno a un minuto en dictar cada palabra, hasta que introdujo un software predictivo en 2014.

Ahora, el doctor Edward F. Chang y sus colegas han desarrollado un método para sintetizar el habla de una persona utilizando las señales cerebrales que están relacionadas con los movimientos físicos empleados de forma natural al hablar. Primero, registraron la actividad cortical (de la corteza del cerebro) de cinco participantes mientras pronunciaban varios cientos de oraciones en voz alta. Usando estas grabaciones, los autores diseñaron un sistema que es capaz de descifrar las señales cerebrales responsables de los movimientos individuales del tracto vocal. Una especie de entrenamiento del algoritmo. Después pudieron sintetizar el habla con un programa de texto a voz. En las pruebas, con 101 oraciones, los oyentes pudieron identificar y transcribir fácilmente el discurso sintetizado. Es decir, suena inteligible y coherente.

Es posible descifrar características del habla que nunca se pronuncian de forma audible

En ensayos separados, se pidió a un participante que pronunciara oraciones y luego las imitara, haciendo los mismos movimientos articulatorios, sin sonido. Si bien el rendimiento con la mímica fue inferior a la del habla fonada, los autores concluyen que es posible descifrar características del habla que nunca se pronuncian de forma audible. Con esto probaron que la máquina lo que ve es realmente cómo el cerebro da instrucciones para producir sonidos, aunque no se emitan.

Esquema de cómo se traduce la actividad cortical en ondas de voz

"Decodificar el habla a partir de la actividad neuronal es un reto porque el habla requiere de un control multidimensional muy preciso y rápido de los articuladores del tracto vocal", explican los autores en su artículo, publicado en Nature. Hablar, en realidad, es una habilidad complejísima y única en el Homo sapiens. "Aquí diseñamos un decodificador neurpnal que aprovecha explícitamente las representaciones cinemáticas (del movimiento) y del sonido codificadas en la actividad cortical humana para sintetizar el habla audible". Las redes neuronales de inteligencia artificial primero descifraron directamente la actividad cerebral grabada en representaciones del movimiento articulatorio, y luego transformaron éstas representaciones en forma de onda sonora.

La investigación mejora las prestaciones de otros dispositivos comunicativos que recurren al llamado interfaz cerebro-computador (BCI, por sus siglas en inglés). De hecho, el trabajo de los expertos Gopala K. Anumanchipalli, Josh Chartier y Edward F. Chang es un avance hacia el desarrollo de un BCI que, en el futuro, podría restaurar el habla en personas con algún tipo de desorden neurológico, como una apoplejía o la esclerosis lateral amiotrófica (ELA), o cuyo tracto vocal está dañado por un cáncer.

En los casos de sujetos con, por ejemplo, parálisis, un BCI puede “leer” sus intenciones directamente del cerebro y usar esa información para controlar dispositivos externos o para mover las extremidades paralizadas, recuerdan los autores. Eso marca un salto respecto al ordenador de Hawking, que requería de un movimiento físico, bien de los ojos o de la mejilla.

Los actuales sistemas de transcripción no permiten más de 10 palabras por minuto

De una manera similar, el desarrollo de los BCI para la comunicación se ha centrado, sobre todo, en dispositivos que registran movimientos no verbales, como los de los ojos o la cabeza, para controlar un cursor que selecciona letras y las convierte en palabras, a un ritmo de hasta ocho o diez por minuto.

Aún lejos del lenguaje natural

Estos avances han mejorado enormemente la calidad de vida de muchas personas, pero aún están lejos de emular una comunicación más fluida y natural, cuyo ritmo oscila entre las 120 y 150 palabras por minuto.

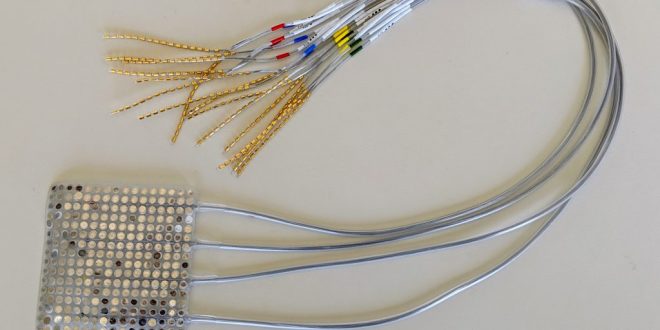

Matriz de electrodos usada en el experimento

“Hemos combinado los métodos más modernos de la neurociencia, del aprendizaje profundo y la lingüística para sintetizar un discurso que suene natural a partir de la actividad cerebral de participantes que no tenían impedimentos de habla”, ha explicado Chang en conferencia de prensa.

Si las personas que ya no pueden producir movimientos relacionados con el habla podrán usar BCI de síntesis de voz es una pregunta que debajn abierta para futuras investigaciones. En particular, después del desarrollo de los primeros estudios de prueba de concepto de BCI para controlar los movimientos de brazos y manos en animales sanos, se plantearon preguntas similares sobre la aplicabilidad de dichos BCI en personas con parálisis. "Los ensayos clínicos han demostrado de manera convincente la comunicación rápida, el control de los brazos robóticos y la restauración de la sensación y el movimiento de las extremidades paralizadas en humanos utilizando estos BCI".

Chartier celebra que puede ser de uso general para cualquier lengua, dado que “todos los seres humanos tenemos el mismo tracto vocal. Entre un idioma y otro, los movimientos podrían ser diferentes para crear ciertos sonidos. Para adaptarlo a otra lengua necesitaríamos datos de esas lenguas y de los movimientos que crean los sonidos”. Todo es dar con el diccionario cerebral adecuado. Estamos ante el futuro brain translate y las compañías tecnológicas ya miran con interés a este tipo de desarrollos.

Te puede interesar

Lo más visto