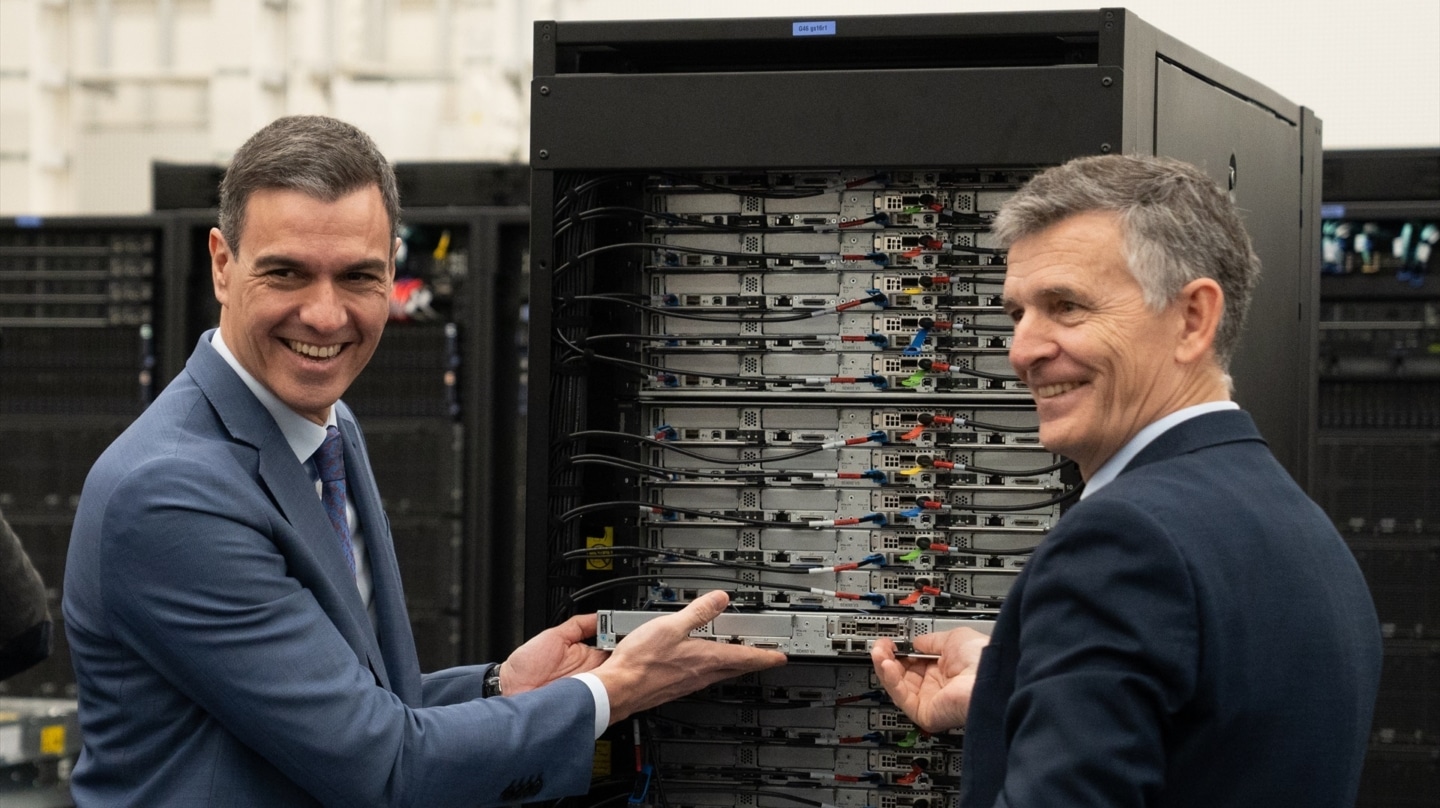

Este domingo, en la víspera de la inauguración del Mobile World Congress (MWC) de Barcelona, Pedro Sánchez anunció que España se ha propuesto crear un gran modelo fundacional de lenguaje de inteligencia artificial entrenado específicamente en español y en el resto de lenguas cooficiales del Estado. Una apuesta clara y firme de nuestro país por subirse al carro de la tecnología de moda, que ha sido recibida con entusiasmo ente los expertos.

El presidente no quiso dar muchos más detalles, más allá de que este nuevo modelo se desarrollará en código abierto y en estrecha colaboración público-privada con el Barcelona Supercomputing Center, la Red Española de supercomputación, la Academia Española de la Lengua y la Asociación de Academias de la Lengua Española. Y que el plan es que la iniciativa sea extensible a los países iberoamericanos.

Como recordaron desde Moncloa, los modelos de lenguaje con IA requieren una gran cantidad de datos lingüísticos para ser entrenados. Pero la balanza está muy descompensada entre idiomas, porque el porcentaje de información en inglés puede llegar a copar el 90% en muchos de los sistemas actuales. Por ello el Gobierno lanza ahora esta iniciativa, que asegura que es pionera a nivel europeo.

Pero vamos a profundizar. Porque quizás lo lógico sería pensar que España va a crear un nuevo ChatGPT, pero en realidad es más complejo que eso. "Cuando nos imaginamos este tipo de sistemas tenemos que visualizar una pila de tres cosas. En el fondo están los corpus, que son volúmenes de datos, normalmente textuales, con los que se entrenan los algoritmos. Por encima están los grandes modelos de IA, que han surgido a raíz de ese entrenamiento. Y la última capa está compuesta por las aplicaciones y los servicios que llegan a los usuarios, que han sido desarrollados a partir de esos modelos", resume Josep M. Martorell, director asociado del Barcelona Supercomputing Center - Centro Nacional de Supercomputación (BSC).

Lo que va a hacer el Gobierno ahora es crear esa capa intermedia, que luego se pondrá a disposición de las empresas para que cada una la moldee como quiera y pueda desarrollar multitud de herramientas, que serán las que podrán usar los ciudadanos en última instancia. Es decir, se trata de una base sobre la que empezar a construir. A día de hoy las compañías españolas que quieran hacer algo así tendrían que ponerse en contacto con las grandes multinacionales estadounidenses. Por eso España va a ganar "soberanía tecnológica".

Lo que está por ver es qué harán las empresas con este modelo. "Se puede utilizar con múltiples fines. Los asistentes conversacionales son una de las posibles aplicaciones pues pueden resumir, traducir textos, y cualquier aplicación relacionada con el lenguaje. Además se pueden utilizar en muchos casos de usos en diferentes campos como el márketing, el descubrimiento científico, para aprender idiomas, etc", asegura Asunción Gómez- Pérez, Doctora en Informática, vicerrectora y Catedrática en la Universidad Politécnica de Madrid (UPM) y miembro de la RAE.

Para el entrenamiento de esta nueva herramienta se utilizarán bases de datos que van desde Wikipedia hasta la Biblioteca Nacional, pasando por noticias de los medios de comunicación públicos españoles, sesiones parlamentarias o incluso el BOE. Es decir, serán siempre datos públicos y que tengan licencias que permitan expresamente que puedan ser usados para entrenar modelos de IA. Así se consiguen dos cosas: que la información sea fiable y que no haya problemas de propiedad intelectual o copyright.

La gran pregunta ahora es cuándo estará disponible. "Este año veremos resultados importantes. A nivel puramente tecnológico, y simplificando mucho, te diría que a día de hoy nuestro modelo tiene un nivel similar al GPT-2 -lanzado en 2019 por OpenAI-. Antes de final de año, y me gustaría incluso que para verano, nos gustaría que alcanzar el nivel de GPT-3, que ya permitiría a cualquier compañía desarrollar aplicaciones sin sesgos y sin grandes problemas. No sólo por su nivel de complejidad, sino porque puede adaptarse a diferentes dominios. Por eso la clave sería crear buenos corpus especializados en diferentes dominios, como temas jurídicos o médicos", detalla Martorell.

De acuerdo con el experto, hay varios retos en el desarrollo de este modelo, más allá del puramente científico. Primero, que el castellano y el resto de idiomas oficiales en España tienen una variedad dialectal muy elevada. Segundo, que aún hay que definir cómo se pondrá a disposición de las empresas una vez esté listo. Y tercero, que hay que tener paciencia. Porque construir un modelo como este no es cuestión de días ni semanas.

Por ahora se desconoce el presupuesto que se destinará a desarrollar este modelo, aunque Martorell da por hecho que la mayor parte del dinero lo aportarán las administraciones públicas. Y es que, aunque se ha anunciado ya, se trata de un proyecto que todavía está "aterrizando", y que aún debe coordinarse con las diferentes instituciones implicadas como la RAE o la Agencia Española de Supervisión de la Inteligencia Artificial, que se creó el año pasado.

El superordenador que lo hará posible

"Este nuevo modelo es una iniciativa extraordinaria y necesaria para que las aplicaciones digitales utilicen un español correcto. Es necesario disponer de un modelo de lenguaje para el español que sea global, para todos los hispanohablantes, y que se nutra de fuentes reputadas que utilicen un español correcto en todas sus variedades. Aunque es mucho más complicado elaborar modelos de lenguaje en aquellas lenguas para las que hay menos información disponible. Por eso será necesario investigar en nuevos enfoques", sostiene Gómez- Pérez.

Esta es una de las claves. Al haber menos información disponible en español que en inglés, entrenar a los modelos para que funcionen correctamente en nuestro idioma es más complicado. Y no hablemos del resto de lenguas cooficiales, que son más minoritarias. Pero España cuenta con una nueva herramienta, que es la que permite abordar este gran reto precisamente ahora. Se trata del MareNostrum 5, un superordenador inaugurado en el BSC el pasado diciembre que ha costado más de 200 millones de euros.

"El MareNostrum 5 es el octavo ordenador más potente del mundo. Ha multiplicado por 30 la potencia de cálculo que teníamos en España hasta la fecha, y nos permite abordar problemas que hasta ahora eran imposibles para nosotros. Lo que antes nos llevaba un año ahora nos lleva dos semanas", explica Oriol Pineda, Jefe de Acceso a Infraestructuras del Barcelona Supercomputing Center, que detalla que en sus instalaciones tienen 15 ordenadores más y otros nueve centros de procesamiento de datos de élite mundial.

Este superordenador permite, además, paliar otro problema clásico de los grandes modelos de IA, que es su impacto en el medio ambiente. "Cuando entrenas modelos a partir de grandes corpus es un proceso computacionalmente muy costoso. Son grandes máquinas trabajando días y semanas, pero si lo haces bien es un proceso que sólo hay que hacer una vez. Y luego cada institución o empresa puede adaptarlo para un uso concreto, algo que es mucho menos costoso a nivel energético. Entonces por un lado restringiremos el entrenamiento para hacerlo una sola vez, y por otro hay que decir que el MareNostrum 5 es el sexto ordenador más sostenible del mundo, y el primero de Europa, según el ránking Green500", relata Martorell.

La opinión de los expertos

Entre los expertos no hay dudas: se trata de una iniciativa positiva y necesaria. Pero a partir de ahí cada uno señala desafíos y beneficios distintos. El Science Media Center España ha contactado con varios de ellos para cuestionarles sobre su opinión acerca de esta iniciativa.

"Por un lado, es una buena noticia, puesto que la gran mayoría de modelos fundacionales han sido creados en inglés. Y siendo el Gobierno el que empuja dicha creación, cumplirá las obligaciones para este tipo de sistemas. Pero por otro hay muchas incógnitas ligadas a su viabilidad (quién proporciona el presupuesto, quién realiza el proyecto, cómo se va a ofrecer para que genere valor a la sociedad, quién va a hacer mantenimiento, cómo se van a controlar sesgos y otras ineficiencias de estos modelos). Hasta que no tengamos más detalles para evaluar su futura viabilidad, queda simplemente como un anuncio de buenas intenciones", asegura Josep Curto, profesor de los Estudios de Informática, Multimedia y Telecomunicación de la UOC.

"El proyecto HPLT (financiado por la Unión Europea) ha recopilado y publicado 7 petabytes de documentos extraídos de la web. Cuando ves la distribución hay en torno a 1.000 veces más datos en inglés que en español. Si nos fijamos en las lenguas cooficiales, esta desproporción es mucho más acusada. Pero pesar de esto, los modelos multilingües funcionan razonablemente bien en español en tareas generalistas. Aunque hay todavía espacio para la mejora y un modelo adaptado al español va a funcionar mejor, desde luego", sostiene Pablo Haya Coll, investigador del Laboratorio de Lingüística Informática de la Universidad Autónoma de Madrid (UAM).

Andreas Kaltenbrunner, investigador líder del grupo AI and Data for Society de la UOC, detalla que el 5,6 % del contenido en internet está en castellano, mientras que el 0,1% en catalán/valenciano. Así que tener LLMs propios en las lenguas del Estado es una iniciativa "muy interesante" para combatir las desventajas respecto al inglés. No obstante, señala que no será una tarea fácil por la cantidad de recursos que tienen los competidores como OpenAI, y quiere ver si enfocándose solo en un conjunto reducido de idiomas no se pierden "las posibles sinergias que se tienen entrenado modelos multilingües con más idiomas".

"Me parece una buena propuesta. Sin duda, la repercusión mediática de ChatGPT ha sido un hito, lo que ha supuesto otra vuelta de tuerca en el desarrollo de la IA. Pero ha sido simplemente una punta de lanza, hay mucho camino por recorrer. Los modelos de ChatGPT son muy generalistas y, para obtener mejores resultados, se necesita pasar a una IA más personalizada. La propuesta es de tal magnitud que o se involucran los gobiernos o no sería posible", afirma Teodoro Calonge, profesor titular del departamento de Informática en la Universidad de Valladolid, que concluye que quizás haya que resolver incluso "obstáculos legales que llevarán su tiempo".

Te puede interesar

1 Comentarios

Normas ›Comentarios cerrados para este artículo.

Lo más visto

hace 1 año

A cuanto nos sale la broma a cada uno? Alguien ha hecho algún cálculo de si esto es viable, rentable o al menos útil? No creo que existan contenidos en euskera o gallego como para hacer un módelo lo suficientemente bueno como para que merezca la pena probarlo, utilidad de esto, entre cero y nada… Pero claro a pagar andaluces extremeños y castellanos… Pero eso sí… España nos roba